Le fichier robots txt est la mise en œuvre de la norme d’exclusion des robots, également appelée protocole d’exclusion des robots.

Cette convention permet d’empêcher les robots d’accéder à tout ou une partie d’un site Web. Il s’agit d’un fichier texte utilisé pour le référencement, contenant des commandes pour les robots d’indexation des moteurs de recherche qui spécifient les pages qui peuvent ou non être indexées.

Le fichier robots.txt n’est pas utilisé pour désindexer des pages, mais pour empêcher qu’elles soient parcourues. Si une page n’a jamais été indexée auparavant, le fait d’empêcher son exploration lui permettra de ne jamais être indexée.

En revanche, si une page est déjà indexée ou si un autre site Web y renvoie, le fichier robots.txt ne permettra pas la désindexation. Pour empêcher une page d’être indexée sur Google, vous devez utiliser des balises/directives noindex, ou la protéger par un mot de passe.

L’objectif principal du fichier robots txt est donc simple : interdire aux robots des moteurs de recherche de parcourir certaines pages à faible valeur ajoutée, mais qui sont quand même utiles pour le parcours et l’expérience utilisateur : comme par exemple le panier d’achat. .

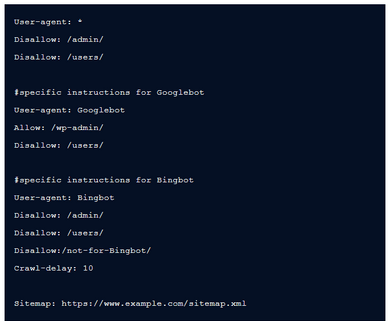

Exemple de fichier robots.txt :

Selon le 2021 Web Almanac, environ 16,5 % des sites web n’ont pas du tout de fichier robots.txt. De plus, tout le monde ne l’implémente pas correctement.

Même s’il n’est pas nécessaire que votre site Web utilise le fichier robots.txt, le fait d’en avoir un peut avoir un effet positif sur votre activité et le trafic de votre site web, en optimisant la façon dont les robots des moteurs de recherche explorent et parcourent votre site.

Le fichier robots txt joue un rôle essentiel du point de vue du référencement. Il indique aux moteurs de recherche la meilleure façon d’explorer votre site Web.

À l’aide du fichier robots.txt, vous pouvez empêcher les moteurs de recherche d’accéder à certaines parties de votre site Web, empêcher le contenu dupliqué et conseiller aux moteurs de recherche comment ils peuvent explorer votre site plus efficacement.

Lorsque vous apportez des modifications au fichier robots.txt, soyez prudent !

Le robots txt en SEO peut rendre accessible certaines pages de votre site web aux moteurs de recherche.

En outre, le fichier robots.txt vous permet de spécifier l’emplacement de votre sitemap. Un sitemap est un fichier texte répertoriant les URL que vous souhaitez faire indexer par les moteurs de recherche. Intégrer un lien dans le fichier robots txt permet aux robots des moteurs de recherche de le trouver plus facilement.

Les fichiers Robots.txt sont publics. Il vous suffit de taper un domaine racine et d’ajouter /robots.txt à la fin de l’URL pour voir le fichier… s’il y en a un !

Attention : évitez d’inscrire des informations privées et confidentielles dans ce fichier.

Vous pouvez trouver et modifier le fichier robots.txt dans le répertoire racine de votre hébergement, en vérifiant l’administration des fichiers ou le FTP du site web.

La modification de votre fichier robots.txt va dépendre du système de gestion de votre site web.

Si vous utilisez un CMS ou une plateforme de commerce électronique, vous avez peut-être accès à des outils ou des plugins dédiés qui peuvent vous aider à accéder au fichier et à le modifier facilement. Par exemple, Wix et Shopify vous permettent de modifier directement le fichier robots.txt.

Note : utilisez un plugin comme Yoast sur WordPress.

Si vous n’utilisez pas de CMS ou de plateforme de commerce électronique, il se peut que vous deviez d’abord télécharger le fichier, le modifier, puis le remettre en ligne sur votre site.

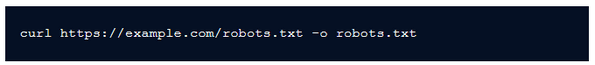

Vous pouvez télécharger le fichier de différentes façons :

Une fois que vous avez téléchargé le fichier robots txt, il vous suffit de le modifier dans l’éditeur de texte de votre choix, comme Notepad (Windows) ou TextEdit (Mac). Veillez à encoder le fichier dans la norme UTF-8 et n’oubliez pas qu’il doit être nommé « robots.txt ».

Après avoir modifié le fichier robots.txt, vous pouvez le charger de la même manière que vous le téléchargez. Vous pouvez utiliser les outils dédiés fournis par votre solution d’hébergement, utiliser les outils intégrés au CMS, ou envoyer les fichiers directement sur le serveur par les protocoles FTP.

Le fichier robots.txt contrôle les zones et pages du site web auquel le robot d’exploration a accès.

Si le Google robot txt n’est pas autorisé à explorer l’ensemble du site, cela peut être risqué. Le fichier robots.txt est cependant très pratique dans certaines situations !

Boost Your Web vous donne des conseils pour optimiser correctement votre fichier robots.txt :

Il est important de ne pas bloquer les sections et pages du site Web qui doivent faire l’objet d’un suivi.

Sauf si les pages sont liées à d’autres pages auxquelles les moteurs de recherche n’ont pas accès ou ont été bloquées, les ressources liées ne sont pas explorées et ne seront pas indexées.

En outre, aucune valeur de lien ne peut être transmise de la page bloquée à la destination du lien. Si vous voulez donner de l’autorité à des pages, il est nécessaire que vous les bloquiez à l’aide d’un autre système de blocage.

D’autres pages peuvent renvoyer directement à la page contenant des informations confidentielles (évitant ainsi les directives de robots.txt dans votre domaine racine ou votre page d’accueil), c’est pourquoi elle peut encore être indexée.

Vous devez utiliser un autre moyen, comme la mise en place d’une protection par mot de passe, ou le recours à la balise méta noindex, pour empêcher la page d’apparaître dans les résultats de recherche de Google.

Google utilise GoogleBot pour la recherche organique et GoogleBot-Image pour la recherche d’images.

La majorité des user agents (ou agents utilisateurs) d’un moteur de recherche suivent les mêmes règles. C’est pourquoi il n’est pas nécessaire de définir des directives pour chaque robot d’exploration de moteur de recherche, mais cela vous permet de contrôler la façon dont le contenu du site sera exploré.

Si vous modifiez le fichier robots.txt et souhaitez le mettre à jour plus rapidement, vous pouvez directement demander la mise à jour en envoyant l’URL du fichier robots.txt à Google.

Vous souhaitez vous faire accompagner par des experts en SEO avec une formation spécialisée ? Contactez Boost Your Web, votre agence de référencement à Vannes !